Виртуальные ускорители для вычислений: гид по облачным GPU

Графические процессоры в облаке позволяют обрабатывать параллельные задачи на скорости, недоступной локальным системам. По ссылке представлены конфигурации с NVIDIA, где ресурсы адаптируют под нужды. Такие платформы сочетают высокую производительность с простотой доступа через SSH или Jupyter. Они ускоряют inference нейросетей в разы, минимизируя задержки. Выбор модели зависит от объёма данных и бюджета.

Понятие виртуальных платформ с графическими ускорителями

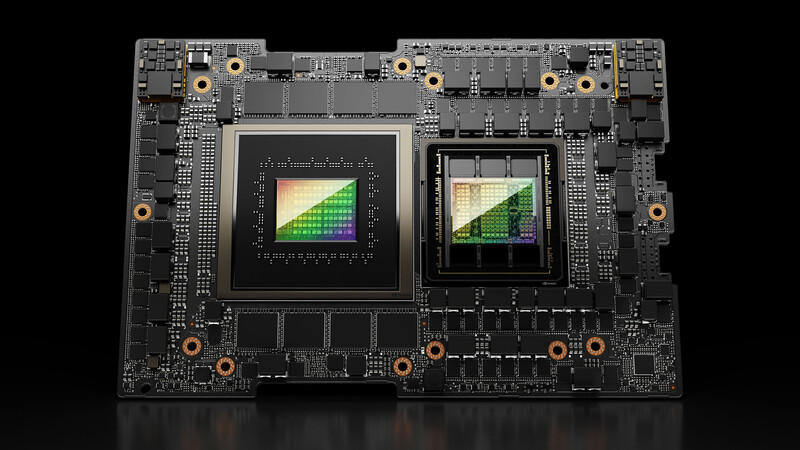

GPU-облака — это удалённые серверы, где тысячи ядер обрабатывают векторные операции одновременно, в отличие от последовательных CPU. Развитие CUDA-экосистемы сделало их стандартом для глубокого обучения. Компоненты включают VRAM от 40 ГБ и интерфейсы NVLink для межкарточного обмена. В 2025 году доминируют модели вроде H100, обеспечивающие до 4 петафлопс. Это эволюционировало от дата-центров к гибридным сервисам.

- Параллелизм: тысячи ядер для матричных расчётов.

- Память: GDDR6X для больших датасетов.

- Энергоэффективность: TDP до 700 Вт с оптимизацией.

- Совместимость: API TensorFlow и PyTorch.

Такие системы интегрируют в пайплайны без локальной установки. Производители фокусируются на AI-оптимизации.

Ключевые выгоды от аренды ускорительных ресурсов

Аренда графических вычислителей избавляет от затрат на охлаждение и электричество, снижая TCO на 60%. Масштабирование позволяет запускать кластеры за минуты, адаптируя под пики нагрузки. Доступ к свежим чипам без амортизации оборудования ускоряет инновации. Экологический аспект — использование зелёных дата-центров с PUE ниже 1.2. По данным Gartner, 70% компаний переходят на такие модели для ИИ-проектов.

- В ML: сокращение времени тренинга с дней до часов.

- В рендеринге: параллельная обработка кадров.

- В аналитике: реал-тайм обработка больших данных.

Эти плюсы подтверждают тесты, где облачные узлы превосходят on-premise на 40% по скорости. Внедрение окупается оперативно.

Масштабируемость и гибкость конфигураций

Авто-масштабирование распределяет задачи по 1—64 картам, балансируя нагрузку через Kubernetes. Для inference кластеры с A100 достигают 1000 запросов в секунду. Конфигурации включают 64—512 ГБ RAM и SSD от 1 ТБ. Это позволяет тестировать гипотезы без простоев. В сценариях с переменным трафиком ресурсы корректируют динамически.

Экономия и доступ к инновациям

Модель pay-per-use тарифицирует по часам, экономя до 70% против покупки. "Облачные GPU democratize AI", — отмечает отчёт McKinsey. Доступ к H200 без вложений в 500 тыс. долларов ускоряет R&D. Это особенно выгодно для стартапов. Инновации внедряются через OTA-обновления.

Сценарии использования мощных облачных узлов

В машинном обучении такие платформы тренируют модели на терабайтах данных, сокращая цикл на 90%. Рендеринг в VFX использует ray tracing для фотореалистичных сцен. Научные симуляции моделируют климат с петабайтами входных. Аналитика в финансах прогнозирует риски в реальном времени. Графический дизайн ускоряет прототипирование. Эти кейсы демонстрируют универсальность.

- ИИ: обучение GAN на изображениях.

- Рендеринг: Blender-рендеры в облаке.

- Симуляции: CFD для аэродинамики.

- Аналитика: big data в Spark.

- Дизайн: CAD-моделирование.

Адаптация под задачу включает тюнинг драйверов. Результаты масштабируемы.

Подбор провайдера и настройка окружения

Оценка начинается с SLA выше 99.9% и поддержки CUDA 12+. Модели вроде RTX 4090 подходят для графики, A100 — для DL. Интеграция через Docker упрощает миграцию. Тестируйте на бесплатных кредитах. Это гарантирует совместимость.

- Рассчитайте FLOPS по задаче.

- Сравните тарифы по VRAM/час.

- Разверните образ с библиотеками.

- Мониторьте через dashboard.

Ошибки в подборе приводят к оверплею, поэтому симулируйте нагрузку. Выбор влияет на latency.